1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

|

hbase org.apache.hadoop.hbase.mapreduce.CopyTable --families=info --new.name=copy3 test:users

create 'copy3',{NAME => 'info', TTL=>'604800',COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true},{NAME => 'header', TTL=>'604800',COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true}

create'copy3',{NAME=>'info',COMPRESSION=>'SNAPPY',VERSIONS=>1,BLOCKCACHE=>true},{NAME=>'header',COMPRESSION=>'SNAPPY',VERSIONS=>1,BLOCKCACHE=>true},SPLITS=>['20190621|','20190622|','20190623|','20190624|','20190625|']

create'copy4',{NAME=>'info',COMPRESSION=>'SNAPPY',VERSIONS=>1,BLOCKCACHE=>true},{NAME=>'header',COMPRESSION=>'SNAPPY',VERSIONS=>1,BLOCKCACHE=>true}

create'copy5',{NAME=>'info',COMPRESSION=>'SNAPPY',VERSIONS=>1,BLOCKCACHE=>true}

create 'copy6',{NAME => 'info', TTL=>'604800',COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true},{NAME => 'header', TTL=>'604800',COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true} 失败

create 'copy6',{NAME => 'info', COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true},{NAME => 'header', COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true}

create 'copy7',{NAME => 'info', COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true},{NAME => 'header', COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true}

create 'copy8',{NAME => 'info', TTL=>'6048000',COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true},{NAME => 'header', TTL=>'6048000',COMPRESSION => 'SNAPPY',VERSIONS => 1,BLOCKCACHE => true}

truncate 'copy3'

hbase org.apache.hadoop.hbase.mapreduce.CopyTable --families=info --new.name=copy3 test:users

hbase org.apache.hadoop.hbase.mapreduce.CopyTable --startrow=20190621090001000-102 --stoprow=20190621090001000-115 --families=info --new.name=copy3 test:users

hbase org.apache.hadoop.hbase.mapreduce.CopyTable --startrow=20190621090001000-102 --stoprow=20190621090001000-115 --families=info --new.name=copy4 test:users

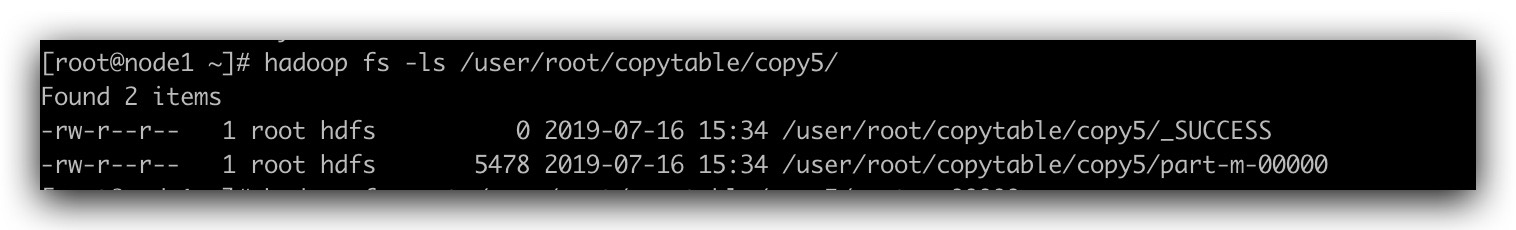

hbase org.apache.hadoop.hbase.mapreduce.CopyTable --startrow=20190621090001000-102 --stoprow=20190621090001000-115 --families=info --new.name=copy5 test:users

hbase org.apache.hadoop.hbase.mapreduce.CopyTable --startrow=20190621090001000-102 --stoprow=20190621090001000-115 --families=info --new.name=copy6 test:users

hbase org.apache.hadoop.hbase.mapreduce.CopyTable --startrow=20190621090001000-102 --stoprow=20190621090001000-115 --families=info --new.name=copy7 test:users

hbase org.apache.hadoop.hbase.mapreduce.RowCounter 'copy3'

|